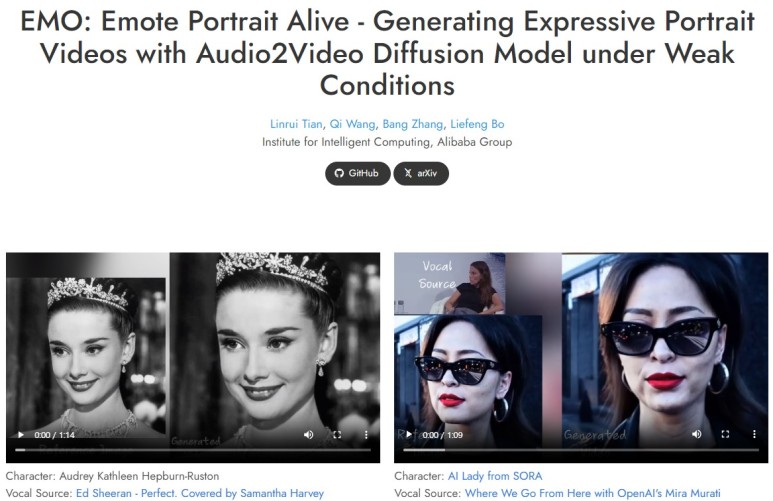

EMO는 Emote Portrait Alive의 약자로, Audio2Video Diffusion Model을 사용하여

약한 조건에서 표현력 있는 초상화 비디오를 생성하는 것을 뜻합니다

단일 참조 이미지와 음성 오디오를 입력하면 표정과 다양한 머리 자세가 포함된 보컬 아바타 비디오를 생성할 수 있으며,

동시에 입력 비디오의 길이에 따라 길이에 관계없이 비디오를 생성할 수 있습니다.

출처: EMO

EMO는 사용자가 인물/캐릭터 이미지와 오디오를 함께 입력하면 →

해당 인물/캐릭터가 오디오 내용에 맞춰 말하거나 노래하는 영상을 생성하는 Audio to Video 모델입니다.

생성된 영상 속 인물의 표정이 풍부하며, 말하는 내용과 입 모양이 자연스럽게 매칭됩니다.

각각 다른 언어라도 어색함 없이 영상처럼 만들어 지네요.

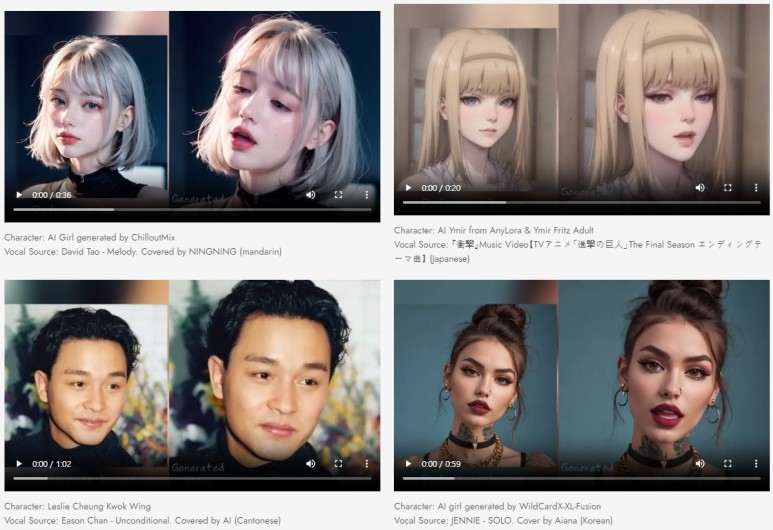

다양한 언어 및 초상화 스타일

다양한 언어로 된 노래를 지원하고 다양한 인물 사진 스타일을 생생하게 구현합니다.

오디오의 음색 변화를 직관적으로 인식하여 역동적이고 표현력이 풍부한 아바타를 생성할 수 있습니다

기술 개요

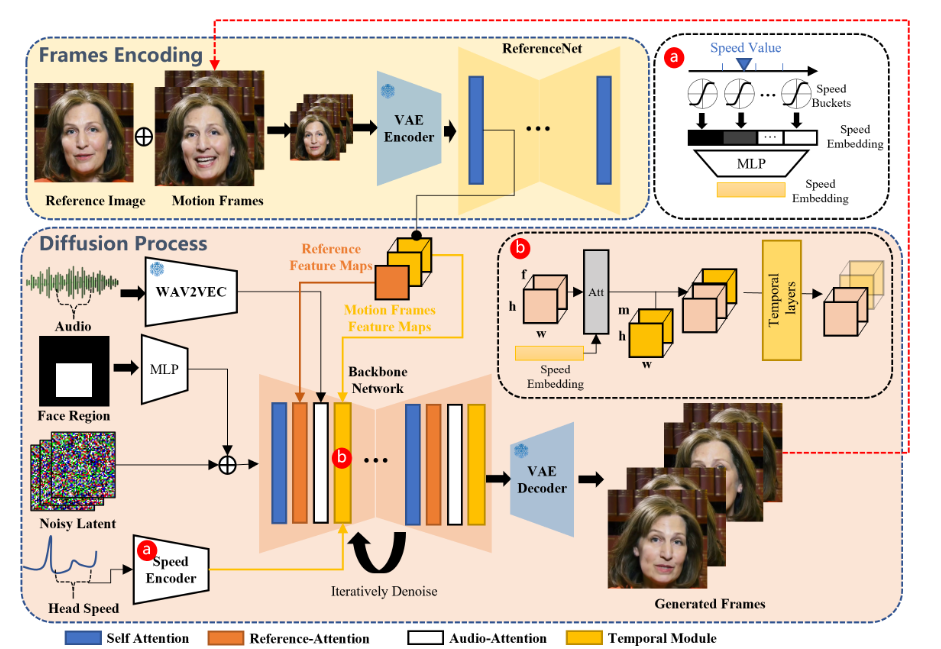

프레임워크는 크게 두 단계로 구성됩니다.

프레임 인코딩이라고 하는 초기 단계에서 ReferenceNet은 참조 이미지와 모션 프레임에서 특징을 추출하기 위해 배포됩니다.

이후 확산 프로세스 단계에서는 사전 훈련된 오디오 인코더가 오디오 임베딩을 처리합니다.

얼굴 영역 마스크는 다중 프레임 노이즈와 통합되어 얼굴 이미지 생성을 제어합니다.

그 다음에는 잡음 제거 작업을 용이하게 하기 위해 백본 네트워크를 사용합니다.

백본 네트워크 내에서는 Reference-Attention과 Audio-Attention이라는 두 가지 형태의 Attention 메커니즘이 적용됩니다.

이러한 메커니즘은 각각 캐릭터의 정체성을 보존하고 캐릭터의 움직임을 조절하는 데 필수적입니다.

또한 시간 모듈은 시간 차원을 조작하고 동작 속도를 조정하는 데 활용됩니다.

출처: EMO

'IT 소식' 카테고리의 다른 글

| 알리익스프레스 초이스 데이 2024년 5월 50%할인 이벤트 (0) | 2024.04.30 |

|---|---|

| 에디파이어MR4 한쪽소리 안나옴 해결법 / 초기불량 / 화이트노이즈 / 후기 (0) | 2024.04.01 |

| 갤럭시 s24 vs s23 스펙 비교 / s24플러스 s24울트라 스펙 가격 (0) | 2024.01.24 |

| Oculus Quest 3 / 오큘러스 퀘스트 3 / 스펙 - 악세사리 - 가격 (0) | 2023.10.30 |

| 아이폰 15 ios 17 기능정리 글 (2) | 2023.09.25 |